|

|

|

|

| Por Eduardo Villanueva Commons Si en una red de telecomunicaciones convencional, como la telefónica, el control reside en el centro de la red porque el diseño de la red hace que así sea, en la Internet el control, si cabe el término, reside en el extremo. Las consecuencias de esta diferencia fundamental incluyen pero no se limitan a que en la Internet se tenga que hacer las cosas por consenso, porque no se puede hacer cambios en un solo lugar que afecten rápidamente a todos; que la Internet necesite un alto grado de coordinación técnica para cambiar aquellas características que no estén funcionando correctamente o que sean vulnerables, como sucede en la actualidad con el spam, que no puede ser controlado porque se requeriría cambios a todo nivel y en todos los extremos para que se tenga éxito; y no por último menos importante, que una innovación puede ser implantado en uno de los extremos y expandirse lentamente, hasta cubrir la Red por completo. La innovación es terreno abierto a cualquier interesado. Esta innovación libre, esta carencia de un centro de control, hacen a la Internet un espacio común, o commons como lo define Lawrence Lessig (2001). Un commons es un lugar al que no sólo cualquier puede entrar, en donde cualquier se puede expresar, sino fundamentalmente en donde cualquiera puede proponer maneras nuevas de hacer las cosas, y donde no se puede imponer reglas a la comunidad. Un espacio esencialmente igualitario y orientado a ser enriquecido no por los grandes logros individuales, sino por la reunión de los pequeños logros colectivos que producen resultados de libre acceso. El sistema de red extremo-a-extremo que crea el commons hace que no haya dueños de la Internet, puesto que se la ha diseñado para que no pueda tenerlos. A su vez, las características técnicas de la Internet son parte de sus características como polity, o lugar donde se hace política. Hay sin duda alguna una política de la Red que sale de esta arquitectura libertaria, y que definida en el código informático mismo, se convierte en su gran motor de desarrollo. Lawrence Lessig, el principal teórico de la Internet como espacio comunitario, propone interpretar a la Internet como una nueva manera de expresión para la creatividad humana, la que encuentra en los commons una forma de trabajar que es definitiva y cualitativamente superior, porque añade al espíritu libertario las posibilidades de la tecnología. Para entender claramente el papel que juega, es necesario reproducir el modelo de Benkler que Lessig usa como base de su análisis (Lessig 2001: 25); en este modelo, las capas corresponden al contenido como expresión de ideas, al código como mecanismo de transmisión en el sentido amplio, incluyendo al idioma pero también al mecanismo técnico, y a la capa física como el medio de transmisión: un espacio abierto, una red específica, un edificio. Controlado quiere decir que alguien puede tomar decisiones sobre lo que se puede o no hacer con una de las capas, mientras que libre implica que no existe forma de limitar el uso de estas capas, aun cuando se deba pagar por usarlas.

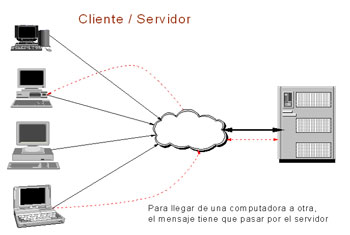

Mientras que en sus formas puras, el espacio público es público porque el libre acceso no se agota en la entrada al sitio, sino porque podemos expresarnos libremente mediante un sistema de comunicación de libre disposición —es decir nuestro idioma—, un auditorio, que por definición es un lugar cerrado y por lo tanto, bajo control de alguien, ya requiere una negociación para lograr el acceso. El sistema telefónico es un medio técnico para la comunicación con el que podemos decir lo que queramos, pero ni la red telefónica, propiedad de un operador, ni el sistema de comunicación, propiedad por lo general del mismo operador aunque interoperativo con otras redes telefónicas, están a nuestra disposición sin que tengamos que acatar algún sistema de reglas. La televisión por cable, en tanto medio masivo, implica control a todo nivel: los medios físicos de transmisión son propiedad de un operador que nos obliga a pagar por el acceso; los mecanismos de codificación también son privados y de pago; finalmente, nuestro control sobre el contenido se reduce a cambiar de canal, o cuando y donde es posible, cambiar de operador. En la Internet, la situación es distinta: mientras que la red física de la que dependemos para conectarnos es totalmente privada, y el acceso a la misma pasa por aceptar las condiciones que ponga un operador dado, el contenido puede ser libre o propiedad de alguien; pero el código —el mecanismo por el cual se lleva a cabo la comunicación— es libre. La base de la Internet reside precisamente en la libre disponibilidad de este código. La razón de la existencia y la viabilidad futura del commons que es la Internet dependen de la libertad de acceso al código. Es el código de la Internet lo que permite esta combinación inusual de contenido controlado y libre al mismo tiempo, y lo que hace tan atractiva a la Red. Pero el código no se limita a cuestiones informáticas, sino que también incluye a las reglas de juego a partir de las cuales se desarrollan las herramientas informáticas. En el caso de servicios como Napster, Kazaa o cualquier otro servicio de intercambio de archivos, la tecnología permite un sistema de libre acceso a contenidos digitalizados, a través del cual se obtiene acceso sin previo pago y sin control a archivos que antes estaban no sólo sujetos a pago, sino sobre todo a control de los derechohabientes; así pues, si alguien deseaba una canción de los años cuarenta, o esperaba a que la disquera la publicara o simplemente no tenía acceso a ella. Gracias a Napster, de pronto no sólo el pago sino el control sobre la edición o no de semejante canción desaparecen del escenario, de forma que las empresas de contenidos no sólo pierden el pago por un disco, sino el manejo completo de todo el armazón comercial sobre el que se basa la industria. Esta situación se crea a partir de la aparición de una innovación llamada computación Par a Par, o P2P. El P2P aprovecha la Internet de maneras inusuales. Diseñada como una red en donde existen computadoras que dan información, y otras computadoras, distintas a las primeras, que reciben información, la arquitectura de la Red cae bajo el concepto general de cliente / servidor, en el que las partes conocen sus funciones y cada una permite hacer a la otra lo que le corresponde. De acuerdo a este diseño, las personas que se conectan a la Internet para acceder a sus servicios, como usuarios de los mismos, no ponen información, archivos o datos a disposición de los demás; por su parte, las computadoras que ponen información, archivos o datos a disposición de los usuarios de la Internet no están pensadas para buscar información. La figura siguiente ilustra mejor el modelo cliente / servidor.

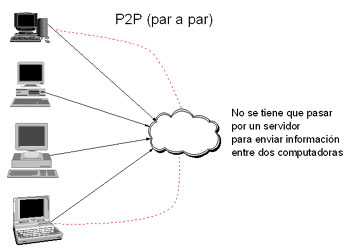

El P2P innova radicalmente al proponer un modelo en el que todas las computadoras pueden dar información al mismo tiempo que la buscan. Mediante recursos técnicos que cambian la relación entre los servidores y las computadoras que solicitan información, el P2P permite que cada computadora pueda dar a conocer qué contenidos específicos, de un formato o ubicación determinada por el usuario, se encuentran en la computadora, para ponerlos a disposición de los demás navegantes de la Internet. Al hacerlo, las porciones específicamente designadas para ese fin son tratadas como “servidores”, desde el punto de vista de los usuarios que se conectan para buscar información. Creado a partir del trabajo individual de Shawn Fanning con el propósito explícito de intercambiar archivos MP3 de canciones, el P2P tuvo a Napster como primera encarnación. Originalmente un sistema relativamente torpe, limitado al formato MP3, ahora el P2P es la base de Kazaa, los bitTorrents o la familia eDonkey, con otros servicios similares que permiten obtener, de otros usuarios, archivos de todo tipo, los que “bajan” o se copian en la computadora solicitante de manera gradual. Películas enteras, por ejemplo. La figura siguiente esquematiza lo que el P2P ofrece.

Así visto, el P2P cambia el mecanismo de control de acceso a los contenidos, que ya no necesitan estar en un servidor específico sino que pueden hallarse en cualquier computadora de la Red. Para el caso de la música el P2P alteró no sólo la manera de acceder a la información, sino incluso toda la industria de la música grabada, principalmente porque cambio las premisas generales de control de contenidos. El resultado es una situación en donde las alternativas que buscan reforzar y explotar el espacio común que es la Internet se ven amenazadas por la intención de los derechohabientes para detener el avance en función de sus intereses específicos. No hay relación directa entre un supuesto “espíritu libertario” y el bando pro-código libre; varios intentos comerciales basados en código de libre acceso y liberador de contenidos han fracasado precisamente porque los derechohabientes han preferido el modelo comercial a cualquier innovación que ponga en el más mínimo peligro sus intereses; lo que se tiene que considerar es el prejuicio a la sociedad que produce esta actitud. Siguiendo a Lessig, esta tensión puede leerse de dos formas, complementarias entre sí: se trata tanto de la tensión entre la tecnología pro-commons y el modelo de propiedad favorable al control de los derechohabientes, en donde una va en direcciones mucho más audaces que la otra; y es la tensión entre formas nuevas de hacer negocios y de garantizar la libre expresión, y las formas antiguas, lo que en realidad refleja la tensión entre los que obtienen beneficios del status quo actual y los que buscarían romperlo o alterarlo, y donde el control es un instrumento de poder. Por el momento, se optará por la primera, puesto que la segunda toma otras formas que vale la pena estudiar más allá del modelo de Lessig. Esta tensión, además, expresa un conflicto entre dos vectores que se oponen entre sí. El problema de esta situación es que para que la visión del commons sea la que prevalezca, tiene que predominar el concepto de uso justo frente a la protección a toda costa del interés privado. Y el commons está perdiendo. Bajo esta idea, cualquier contenido protegido por derechos de autor puede ser usado sin permiso del poseedor de los derechos siempre y cuando sea para uso personal, y sin posible explotación comercial. El uso justo permite que una persona fotocopie partes de un libro, lo cite y eventualmente lo use como base para desarrollar argumentaciones académicas; también permite copias de un disco en un casete. La clave reside en el uso personal. Como uso personal también se entendía, en los años iniciales de la expansión de la Red, el poner en un servidor de FTP una lista de éxitos compilada por una revista de los EEUUAA, o los sonidos de un episodio de Star Trek; a fin de cuentas, no había intención comercial, ni tampoco se entendía que con esto el dueño del producto original pudiese ser perjudicado. Los dos ejemplos mencionados son reales, experimentados por el autor de este trabajo hacia mediados de 1994, y rápidamente puestos fuera de la ley a través de acciones legales y retirados de la red por los propietarios de los derechos. Esto no quiere decir que no se pudiesen conseguir, así como otros contenidos; lo que quedaba claro es que la intención de los usuarios, que no pretendían para nada trasgredir derechos y sí, más bien, facilitar el acceso a información que en principio no era de consulta fácil por todos los conectados a la Red, era interpretada de manera muy distinta por los propietarios de la información2. La cuestión se mantuvo en una tregua similar a la que gobierna el software ilegal en manos de personas naturales, situación que por lo general no preocupa significativamente a los productores, los que gastan energías y recursos en detener el uso de software sin licencia por parte de personas jurídicas. Sin embargo, la popularización de la Red se unió a Napster para cambiar la situación. Conforme el aumento de usuarios provocó que las trasgresiones a los derechoshabientes aumentaran, la aparición de Napster convirtió el panorama de una situación incómoda pero manejable a una amenaza completa e integral a la estabilidad y futuro del negocio de la música. Esto se explica porque Napster, al poner en manos de cualquier persona, sin costo significativo y sin control alguno por parte de los derechohabientes, cantidades ingentes de contenido musical, cuestionaba la viabilidad de la estructura misma del negocio, puesto que lo que sustenta al oligopolio mundial de la música, basado en cadenas de promoción y distribución muy ensambladas, amarradas además con los propietarios de radios privadas y promotores de conciertos en el mundo desarrollado, y manejado por apenas cinco empresas que controlan el 80% de las ventas a nivel mundial , es precisamente la capacidad de decidir qué, cuando y cómo se vende música en el mundo. Napster representaba algo más grave que la pérdida de ingresos por no pago de derechos de autor: significaba el fin del control sobre la música comercial ejercido por estas empresas. Por extensión, y tomando en cuenta que los conglomerados del entretenimiento no se limitan a la música, el debate se orienta hacia la protección de esos negocios in toto, obviando sutilezas que podrían servir para permitir a algunos hacer las cosas con más libertad. Se puede criticar la proporción de la respuesta, así como la falta de coherencia entre las supuestas causas de estos reclamos (los derechos de los músicos) y la realidad de la estructura de ganancias y su repartición a los músicos; también se puede poner en debate la supuesta relación causa-efecto entre la existencia de Napster y sus sucesores y la caída de ventas que experimenta la industria musical. Pero lo que no se puede cuestionar es que, si por un lado Napster ofreció una nueva visión de cómo trasladar contenidos prescindiendo de las cadenas tradicionales de distribución, por otro la industria demostró su increíble capacidad de respuesta legal, mas no tecnológica o comercial. Tecnológicamente, la industria musical no logró crear alternativa alguna para bloquear o proteger sus contenidos que no haya sido rápidamente superada por los especialistas o los hackers. Pero legalmente y en el territorio de los Estados Unidos, y arrastrando a través de convenios internacionales y acuerdos comerciales a Europa y el resto del mundo desarrollado, la industria ha logrado que se impida el funcionamiento a Napster, ha conseguido, al menos a nivel de proyecto de ley, un permiso para hackear las computadoras de los usuarios de servicios sucesores de Napster e impedirles continuar bajando archivos4, y esta trabajando para lograr nuevas leyes, que impidan incluso el establecimiento de relaciones comerciales con países en donde no se considere una ofensa penal el uso de software para acceder a contenidos protegidos por derechos de autor; previamente, y en trabajo conjunto con toda la industria de los contenidos, se ha logrado extensiones continuas de los plazos de duración de los derechos de autor, extendiéndolos setenta años después de la muerte del autor o a noventa y cinco años después de su creación si se trata de propiedad de personas jurídicas. Finalmente, se está proponiendo que no se pueda construir aparato alguno o introducir al mercado tecnología alguna que no cuente con recursos diseñados en el hardware mismo para impedir el acceso a materiales no autorizados, a través de un sistema de marcas de agua digital que requiera una declaración ante facto del interesado en reproducir información digital de que cuenta con los permisos. Todas estas acciones encuentran eco rápido en la Organización Mundial de la Propiedad Intelectual, y son integradas a los acuerdos internacionales. Todo esto para impedir que la llamada Darknet, o red oscura, creada a través de los sistemas de intercambio, perdure; pero muchos opinan (Biddle et al., 2002) que es imposible detener a la Darknet, más allá que sus encarnaciones específicas, como Napster o AudioGalaxy, puedan ser desbaratadas. El problema principal de esta andanada legal en los EEUUAA, que no se limita a la música sino que incluye a todos los ramos de la industria del entretenimiento (Grimmelmann 2001) es que amenaza con consagrar mundialmente la prioridad que tienen los propietarios corporativos de derechos frente a los usuarios que solían estar amparados por doctrinas de uso justo que ya no se aceptan en los mismos términos; este resultado amenaza una de las virtudes principales que la Internet parecía ofrecer a sus usuarios, la que era la flexibilidad y facilidad para intercambiar información sin las limitaciones propias de la materialidad de los formatos previamente existentes. Incluso en el caso relativamente trivial de información supuestamente de libre acceso, puede producirse intentos de bloquear la reproducción o difusión sin permiso previo y explícito del derechohabiente: en Inglaterra, la publicación de estadísticas de los partidos de la Liga Premier de fútbol exige permiso previo, lo que incluso llevo a la amenaza de un boicot por parte de los periodistas deportivos. Las consecuencias de semejante razonamiento para la expresión individual no se limitarán a impedir bajar una película entera por la Internet: también implican que la propiedad intelectual, entendida en su sentido más conveniente para los derecho habientes, será la que mande sobre las intenciones personales. Las estructuras tradicionales de creación, distribución y uso del conocimiento quedan así quebradas, porque es imposible esperar que el consumo de información y el uso de sistemas de comunicación puedan sostenerse cuando los precios suben a cambio de servicios más restrictivos y menos flexibles. El control corporativo ataca el commons y complica la viabilidad de las industrias de la información, entre las que se incluye a la actividad académica. Este razonamiento puede parecer excesivo y ciertamente alejado de la experiencia cotidiana de nuestras realidades latinoamericanas; pero al mismo tiempo, la interconexión permanente que ofrece la tecnología encarnada en la Internet viene acompañada por una creciente interconexión institucional (Mattelart 1998: 94-96). Los acuerdos y compromisos que los Estados se ven obligados a firmar para participar en acuerdos internacionales de comercio y finanzas demandan a su vez el aceptar las reglas de juego: estas son cada vez más directas, y pasan por el control que los grandes conglomerados del entretenimiento y la información ofrecen a nivel global. Nuestras instituciones se adecuan al nuevo marco tan rápido como nuestras prácticas lo hacen con la tecnología. Quizá la diferencia radique en que nuestras prácticas gocen de más autonomía que nuestras instituciones, gracias a la precariedad institucional de nuestros países. Como consuelo, sirve de muy poco. Una respuesta: wikis Esta apropiación de la Internet no ha sido habitualmente considerada en las interpretaciones habituales sobre los cambios recientes que la tecnología y los nuevos medios nos ofrecen como heraldos. Concepciones de la sociedad de la información comunes a los ejercicios burocráticos estatales y multilaterales insisten en la conectividad, en el comercio electrónico o en el gobierno y servicios electrónicos, pero el potencial para ampliar el debate público y aportar a una discusión más alturada, que puede provenir de la participación en la construcción de contenidos de la Red, no suele ser puesta en primer plano, ni mucho menos. Es la iniciativa individual, expresada a través de herramientas o proyectos menores, la que hace tan interesante, tan vital a la Internet. El commons de Lessig se expresa en los proyectos de los hackers que son capaces de construir un navegador ideal colectivamente, en la actividad de los bloggers, o en los pequeños espacios liberados en donde se discute, se colabora y se re-imagina la Red. Verdaderas pequeñas sociedad de la información, los rincones no comerciales, los espacios liberados de la Red pueden ser caóticos y llenos de ruido, difíciles de aprehender y de convertir en negocio, pero nos muestran el futuro mejor que cualquier mega proyecto financiado por grandes empresas o respaldado por presupuestos gubernamentales. Sin duda, los weblogs son un ejemplo básico, y al mismo tiempo muy individualista, de esta tendencia. Si bien la posibilidad de expresión que el weblog ofrece es significativa, y la existencia de weblogs útiles y relevantes sirve como demostración de la pertinencia del concepto para hablar de la web colaborativa, lo cierto es que el grueso de los weblogs son esencialmente formas individualistas de comunicación. Pero existen alternativas mucho más interesantes que revisar, como los Wikis. Wiki wiki quiere decir “rápido” en hawaiiano. Es también el nombre de un método sencillo para hacer páginas web al vuelo, creado por Ward Cunningham <http://www.c2.com/cgi/wiki?WikiWikiWeb> y puesto a disposición de la comunidad de usuarios de la Internet. Definida como una aplicación de informática colaborativa, o software social, la idea de un wiki es crear una página que no sólo pueda ser leída por cualquiera, sino que también pueda ser editada por cualquiera. Suena completamente contra intuitivo crear una página que cualquiera pueda modificar, pero la idea es en realidad muy útil como piedra angular de una Web que en vez de ser un espacio controlado por autores específicos sirva como alternativa de creación colectiva. Un wiki sirve como mecanismo para que muchas personas interactúen de manera fluida y transparente, sin intervención alguna de un editor, permitiendo elaborar contenidos muy sofisticados. Como dice Cunningham en su FAQ <http://www.c2.com/cgi/wiki?WhyWikiWorks>: todos comparten sentido de responsabilidad porque todos pueden contribuir, por lo que se produce un fuerte compromiso de la WikiCommunity para mantener los wikis limpiecitos, dado que todos los usan y por ello todos quieren que se pueda usar. Finalmente: “also it's fun to participate, and people play nice when the game is fun”. La manera más simple de entender los wikis es visitar la Wikipedia, una enciclopedia colaborativa basada en un enorme wiki, que permite a los lectores ser también redactores de los artículos, y donde además encontrarán una explicación bastante clara de qué es un wiki. Esta idea cooperativa facilita contar con mucha más gente de la que normalmente podría involucrarse en un proyecto formal de redacción de una enciclopedia, y si bien puede ser una pequeña invitación al caos también demuestra que, si se actúa de buena fe, se puede efectivamente participar de una pequeña sociedad de la información global como creador, desde cualquier lugar del mundo. La Wikipedia <http://es.wikipedia.org> para la versión en español) no es perfecta, pero es un excelente primer paso, en muchos idiomas, hacia una especie de bibliotheca universalis en donde todo el conocimiento humano esté representado. ¿Son los distintos wikis un ejemplo de commons? Al menos tienen la virtud de permitir al usuario común el participar no sólo de la distribución sino también de la creación de conocimiento, en una escala mucho más asequible que aquella de un proyecto como el Firefox, el nuevo navegador de Mozilla. Es difícil que un usuario del común pueda hacer algo más que usar un producto como Firefox, pero sí puede aportar, con un mínimo de esfuerzo y mucho de buena voluntad, a un wiki como la wikipedia. Pero lo que haría interesante a los wikis es que extienden el concepto de commons más allá del libre acceso para proponer una alternativa mucho más sistemática de participación. El éxito de un proyecto como la wikipedia requiere que además de la cesión al espacio colectivo de conocimiento de los aportes que se puedan hacer, también se ofrezca trabajo, como lo requieren ya los diversos proyectos colaborativos de software (GNU, Linux, Mozilla, Public Library of Science en cierta medida). A esto debe sumarse además que el wiki requiere reconocerse par de muchas personas con las que la colaboración no puede tomar las formas concretas de la producción de software; el wiki permite a cualquiera intervenir sobre el trabajo realizado de una manera mucho más directa, e inherentemente estructural, que en los casos anteriores. El control, que aún a pesar de la naturaleza abierta, existe en el commons tipo Mozilla, no tiene sentido en el wiki; su existencia presupone que abandonemos la noción misma de que alguien tiene más autoridad que otro para decidir qué es lo correcto, al menos autoridad asignada de antemano. Lo que tenemos es una apuesta por un sistema homeostático, tendiente al equilibrio, en el que el reconocimiento a los pares más capacitados para opinar sea el resultado post facto de una comunidad que entrega autoridad en los hechos. Es la lógica meritocrática aplicada más allá de los ámbitos estructurados tradicionales, lo que rige a un wiki. Si aceptamos los testimonios del creador de la wikipedia, la tendencia homeostática de este espacio comunitario es claramente constatable en la manera como los distintos participantes han aceptado, de buena fe y por pura buena voluntad, tomar los roles que en cada caso sus propios recursos y medios les han permitido tomar. Más allá de intentos específicos de agresión a la wikipedia, por vándalos de distinto cuño, el grueso del trabajo es hecho por un conjunto de especialistas que se han ganado la confianza del grupo en los hechos, pero que no han reclamado para sí más reconocimiento que el que sus opiniones sean respetadas por sus pares. El pingüino de Coase Los modelos tradicionales de producción, según la clásica teoría de costos de transacción de las firmas de Ronald Coase, escrita en 1937 y usada como base de la reflexión de Benkler, son las organizaciones, que cuentan con empleados que trabajan por una remuneración y que venden sus capacidades, entregando el resultado de su creatividad para su explotación por los capitalistas, y los individuos, que actúan para su propio beneficio en el mercado. En el primer caso, la dirección de las acciones de los empleados recae en los gerentes; en el segundo, en la interpretación de las señales de precios que los individuos hacen como actores en un mercado. En el modelo que Benkler llama “producción de pares orientada al commons”, grupos de individuos se comprometen en colaborar en proyectos de gran escala siguiendo un conjunto muy variado de motivaciones sociales, sin considerar la ganancia a obtener o las instrucciones de superiores. La factibilidad de este modelo depende de la abundante disponibilidad de recursos intelectuales y su acceso también abundante a recursos de capital, como lo son las redes de comunicación y las computadoras conectadas a través de ellas. La Internet actúa como facilitador técnico de la producción, especialmente si se considera que el costo de acceso es casi irrelevante para aquellos que más probablemente trabajen en estos proyectos, miembros de comunidades académicas o de investigación, los que además también estarán más interesados en el tipo de “remuneración” que ofrece este modelo. El ejemplo “canónico” es Linux (cuyo símbolo es un pingüino), donde lo que se necesitó para lograr el producto en uso fue tanto la disponibilidad de recursos de capital como de recursos humanos con propósitos no mercantiles, pero sí con intenciones de lograr prestigio y reconocimiento por los pares y oportunidades económicas ulteriores a partir de este prestigio y reconocimiento. Algo parecido podría estar sucediendo con el caso específico de la Wikipedia, sus publicaciones hermanas agrupadas en wikimedia.org, y con otros ejercicios de producción de contenido intelectual por wikis. Los profesionales académicos e investigadores son precisamente los más interesados en lograr prestigio antes que remuneración directa, como estudios clásicos (Merton 1988, por ejemplo) lo demuestran. Si bien el argumento de Benkler se refiere a la lógica de producción de software, la estructura comunitaria de los wikis también termina comportándose de maneras similares, puesto que la tendencia homeostática ya mencionada resulta del establecimiento de jerarquías no coercitivas, sino meritocráticas; el conocimiento creado, que toma una forma distinta de aquel consagrado en productos como el software libre pero que igualmente parte de las mismas reglas y acepta los principios de copyleft, entre otros, es puesto a disposición de comunidades más amplias sólo tras haber superado la barrera de aceptación social que la comunidad de cada wiki parece interesada en crear, siempre de forma implícita. La racionalidad económica del tercer modelo de Benkler se impone porque ofrece más retribución que el intentar funcionar en el mercado, donde no habría muchas opciones, o en empresas, que están de retirada de muchos mercados de producción de conocimiento por los problemas creados por tecnologías como la Web o el P2P. Estaríamos pues, ante la aparición de un modelo nuevo de creación intelectual que ofrece un conjunto elevado de ventajas para los intelectuales y creadores de países como los que conforman América Latina. Dado que la dirección de los proyectos resulta de una iniciativa colectiva, fácil de identificar y de motivar, y que la participación en los proyectos no requiere de condiciones de acceso a mercados que favorecen a los profesionales reconocidos formalmente por las economías desarrolladas, la creatividad puede expresarse con más libertad. Dado que los productos finales no están sometidos a la racionalidad mercantil de la economía global, la posibilidad de recibir los beneficios del acceso aumenta y quizá puede compensar las limitaciones de acceso al conocimiento creado por medios convencionales en el mercado global de la información, tal como se ha detallado antes. Hay que decirlo: tal vez estamos ante un espejismo. Quizá la racionalidad económica capitalista tradicional se imponga al largo plazo5, y la idea de un tercer modelo tenga tanta relevancia como de un tercer mundo. Pero mientras tanto, la creatividad expresada en el commons y su distribución abierta, su tendencia a la homeostasis en la asignación de recursos y de proyectos, sean una oportunidad para crear y alimentarse de la creación. Los wikis pueden servir como ejemplo de una opción transformativa de la producción intelectual que muestra más que un producción, una opción de organización intelectual que permite volver a entusiasmarse con el futuro de la sociedad en red. Lima, noviembre del 2004 Notas: *Partes

de este artículo serán publicadas en Senderos

que se bifurcan: dilemas y retos de la sociedad de la información,

Lima: Pontificia Universidad Católica del Perú, 2005.

Referencias: Benkler, Yochai (2002) Eduardo Villanueva Departamento de Comunicaciones, Pontificia Universidad Católica del Perú, |